Apache Hudi C位!云计算一哥AWS EMR 2020年度回顾

1. 概述

成千上万的客户在Amazon EMR上使用Apache Spark,Apache Hive,Apache HBase,Apache Flink,Apache Hudi和Presto运行大规模数据分析应用程序。Amazon EMR自动管理这些框架的配置和扩缩容,并通过优化的运行时提供更高性能,并支持各种Amazon Elastic Compute Cloud(Amazon EC2)实例类型和Amazon Elastic Kubernetes Service(Amazon EKS)集群。Amazon EMR方便数据工程师和数据科学家通过Amazon EMR Studio(预览版)和Amazon EMR Notebook轻松开发、可视化和调试数据科学应用程序。

可以参考来自客户在2020 AWS re:Invent大会上的一些talk

- How Nielsen built a multi-petabyte data platform using Amazon EMR

- Contextual targeting and ad tech migration best practices

- The right tool for the job: Enabling analytics at scale at Intuit

以下博客提供了更多信息

- How the Allen Institute uses Amazon EMR and AWS Step Functions to process extremely wide transcriptomic datasets

- How the ZS COVID-19 Intelligence Engine helps Pharma & Med device manufacturers understand local healthcare needs & gaps at scale

- Dream11’s journey to building their Data Highway on AWS

- Enhancing customer safety by leveraging the scalable, secure, and cost-optimized Toyota Connected Data Lake

回顾2020年,EMR团队致力于以较低的价格提供更好的Amazon EMR性能,并使Amazon EMR在LakeHouse架构中更易于管理和更易于分析,本篇文章总结了过去一年的主要改进。

2. 差异化的引擎性能

Amazon EMR简化了大数据环境和应用程序的构建和运维,可以在几分钟内启动EMR群集,并且无需担心基础架构设置、集群设置、配置或调优。Amazon EMR负责这些任务,可以使得团队集中精力专注业务开发。除了避免构建和管理自己的基础架构来运行大数据应用程序的运维外,Amazon EMR还提供了比开源发行版更好的性能,并提供了100%的API兼容性。这意味着可以以更快速度运行工作负载而无需修改任何代码。

适用于Apache Spark的Amazon EMR运行时是针对Spark进行性能优化的运行时。我们首先在2019年11月在Amazon EMR 5.28.0版中引入了适用于Apache Spark的EMR运行时,并使用TPC-DS基准的查询来衡量相较于开源Spark 2.4的性能提升。测试结果表明相比开源版本查询执行时间的平均快了2.4倍,总查询运行时间快了3.2倍,最新结果表明Amazon EMR 5.30的运行速度是没有运行时的3倍,这意味着运行PB级数据可以以不到传统本地解决方案一半的成本进行规模分析。

我们还改善了Hive和PrestoDB的性能。2020年4月我们宣布从Amazon EMR 6.0开始支持Hive低延迟分析处理(LLAP)服务。测试表明在Amazon EMR 6.0上使用Hive LLAP比Apache Hive快两倍。2020年5月我们在Amazon EMR 5.30中引入了PrestoDB的Amazon EMR运行时,使用TPC-DS基准查询比较了使用运行时的Amazon EMR 5.31与未使用运行时的Amazon EMR 5.29,测试结果表明使用Amazon EMR 5.31和PrestoDB的运行时,查询执行时间的平均值快2.6倍。

3. 更简单的增量数据处理

Apache Hudi (Hadoop Upserts, Deletes and Incrementals)是一个开源数据管理框架,用于简化增量数据处理和数据管道开发,基于Apache Hudi,可以在Amazon Simple Storage Service(Amazon S3)数据湖中执行记录级的插入,更新和删除,从而简化构建变更数据捕获(CDC)管道,借助此功能你可以遵守数据隐私法规并简化数据提取管道,以处理来自流式管道输入和事务系统CDC等来源的迟到或更新的记录。Apache Hudi与开源大数据分析框架(例如Apache Spark,Apache Hive和Presto)集成,并以Apache Parquet和Apache Avro等开放格式维护Amazon S3或HDFS中的数据。

我们从2019年11月的Amazon EMR 5.28版本开始支持Apache Hudi。2020年6月Apache Hudi从孵化器毕业,并发布了0.6.0版本,我们在Amazon EMR 5.31.0、6.2.0及更高版本支持了该版本。Amazon EMR团队与Apache Hudi社区合作开发了一个新的引导功能特性,该功能用于将Parquet数据集转化为Hudi数据集,而无需重写数据集。此引导功能可加快从现有数据集迁移至Apache Hudi数据集过程,经过测试,使用Amazon S3上的1 TB Parquet数据集,引导执行的速度比批量插入快五倍。

在2020年6月,从Amazon EMR版本5.30.0开始支持了HoodieDeltaStreamer实用程序,该实用程序提供了一种从许多来源(包括AWS数据迁移服务(AWS DMS))提取数据的简便方法,通过此集成,可以以无缝,高效和连续的方式将数据从上游关系数据库提取到S3数据湖中。有关更多信息,请参阅使用Amazon EMR和AWS数据库迁移服务上的Apache Hudi将记录级别变更从关系数据库应用于Amazon S3数据湖

Amazon Athena和Amazon Redshift Spectrum增加了对基于S3的数据湖中的Apache Hudi数据集查询的支持。Athena于2020年7月宣布支持查询Hudi表,而Redshift Spectrum 9月宣布支持查询Hudi表。你可以继续使用Amazon EMR中的Apache Hudi对数据集进行更改,然后从Athena和Redshift Spectrum查询Apache Hudi写入时复制(CoW)数据集的最新快照。

4. 差异化的实例性能

除了通过Amazon EMR运行时提供更好的软件性能外,EMR团队还提供了更多的实例选项,可以选择为工作负载提供最佳性能和成本的实例,可以根据应用程序的要求选择在群集中配置哪些类型的EC2实例(标准,高内存,高CPU,高I / O),并完全自定义群集来满足需求。

2020年12月,我们宣布Amazon EMR现在支持6.1.0、5.31.0及更高版本的M6g,C6g和R6g实例,可以使得能够使用由AWS Graviton2处理器实例,AWS使用64位Arm Neoverse内核定制设计了Graviton2处理器,为Amazon EC2中运行的云工作负载提供最佳的价格性能。尽管性能优势会因工作负载的不同特性而有所不同,基于TPC-DS 3 TB基准测试表明,Apache Spark的EMR运行时与Graviton2相比,性能提高了15%,成本降低了30%。

5. 更容易的集群优化

我们还使优化EMR群集变得更加容易。2020年7月我们推出了Amazon EMR Managed Scaling,这项新功能可自动调整EMR集群大小,从而以最低的成本实现最佳性能。EMR托管扩展无需预先预测工作负载模式,也无需先深入了解应用程序框架(例如Apache Spark或Apache Hive)的规则,相反只需要指定集群最小和最大计算资源限制,Amazon EMR会根据工作负载监视关键指标并优化集群大小以实现最佳资源利用率,Amazon EMR可以在高峰期扩大集群规模,并在闲置期间优雅地缩减集群规模,从而将成本降低20–60%。

Amazon EMR 5.30.1及更高版本上的基于Apache Spark,Apache Hive和YARN的工作负载均支持EMR托管扩展,EMR托管扩展支持EMR实例队列,可以无缝扩展竞价型实例、按需实例以及保留的一部分实例,它们都在同一集群中,可以利用Managed Scaling获取最低成本配置的集群。

2020年10月,我们宣布Amazon EMR支持配置EC2竞价型实例的容量优化分配策略,容量优化分配策略会自动利用可用的备用容量,同时仍然可以利用竞价型实例提供的大幅折扣,这为Amazon EMR提供了更多选择。

6. 工作负载合并

以前需要在Amazon EC2上使用完全托管的Amazon EMR或在Amazon EKS上管理Apache Spark之间选择。在Amazon EC2上使用Amazon EMR时,可以从多种EC2实例类型中进行选择以满足价格和性能要求,但是不能在集群上运行多个版本的Apache Spark或其他应用程序,并且不能为非Amazon EMR应用程序使用未使用的容量。在Amazon EKS上对Apache Spark进行自我管理时必须进行繁重的安装、管理和优化,Apache Spark才能在Kubernetes上运行,并且无法从Amazon EMR优化运行时受益。

2020年12月,我们宣布Amazon EKS上的Amazon EMR合并,这是Amazon EMR新的部署选项,可以在Amazon EKS上运行完全托管的开源大数据框架。如果已经使用Amazon EMR,则可以在同一Amazon EKS集群上将基于Amazon EMR的应用程序与其他基于Kubernetes的应用程序合并以提高资源利用率并使用常见的Amazon EKS工具简化基础架构管理。如果当前正在Amazon EKS上自我管理大数据框架,则现在可以使用Amazon EMR来自动进行设置和管理,并利用优化的Amazon EMR运行时来提供更好的性能。

7. 更高的开发生产力

使用Amazon EMR的目标不仅是要为大数据分析工作负载实现最佳的价格性能,而且还要提供业务新见解。

2020年11月我们发布了Amazon MWAA,这是一项完全托管的服务,可轻松在AWS上运行Apache Airflow的开源版本以及构建工作流以运行提取,转换和加载(ETL)作业和数据管道。Airflow流程使用Athena查询从Amazon S3等来源检索输入,在EMR集群上执行转换,并可以使用所得数据在Amazon SageMaker上训练机器学习(ML)模型。使用Python编程语言,将Airflow中的工作流编写为有向非循环图(DAG)。

在AWS re:Invent 2020上我们介绍了EMR Studio的预览,EMR Studio使数据科学家可以轻松地开发、可视化和调试用R,Python,Scala和PySpark编写的应用程序。它提供了完全托管的Jupyter笔记本以及Spark UI和YARN Timeline Service之类的工具来简化调试,用户可以将应用程序所需的自定义Python库或Jupyter内核直接安装到EMR集群,并可以连接到代码存储库(例如AWS CodeCommit,GitHub和Bitbucket)进行协作。

EMR Studio内核和应用程序在EMR群集上运行,因此使用针对Apache Spark进行了性能优化的EMR运行时可以获得分布式数据处理的优势。也可以在AWS Service Catalog中创建集群模板以简化数据科学家和数据工程师的工作负担,并可以利用在Amazon EC2/Amazon EKS上运行的EMR集群。

8. 统一治理

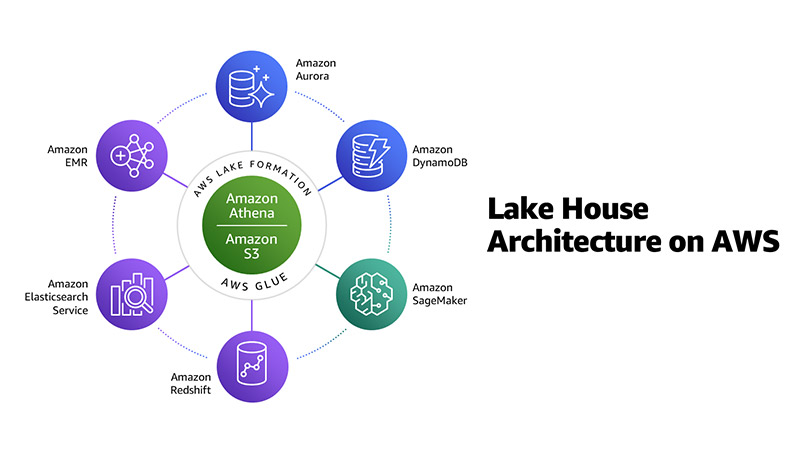

在AWS我们建议使用现代化的Lakehouse架构来构建云上数据和分析基础架构。这不仅涉及将数据湖与数据仓库集成在一起,而且还涉及将数据湖、数据仓库和专用分析服务集成在一起,并实现统一的治理和数据移动。

如下图所示,Amazon EMR与Amazon S3,Amazon Redshift等一起构成AWS上Lakelouse体系结构。

现代分析体系结构中最重要的部分之一就是可以授权、管理和审核对数据的访问。AWS提供了细粒度的访问控制和治理,可以从一个控制点管理跨整个数据湖的数据访问以及专用数据存储和分析服务。

在2021年1月Amazon EMR集成了Apache Ranger,Apache Ranger是一个开源项目,为Hadoop和相关的大数据应用程序(如Apache Hive,Apache HBase和Apache Kafka)提供授权和审核功能。从Amazon EMR 5.32开始,Apache Ranger 2.0插件可启用对Apache SparkSQL,Amazon S3和Apache Hive授权和审核功能。可以设置多租户EMR集群,使用Kerberos进行用户身份验证,使用Apache Ranger 2.0进行授权,以及为数据库、表、列和S3对象配置细粒度的数据访问策略。

Apache Hudi C位!云计算一哥AWS EMR 2020年度回顾的更多相关文章

- Apache Hudi助力nClouds加速数据交付

1. 概述 在nClouds上,当客户的业务决策取决于对近实时数据的访问时,客户通常会向我们寻求有关数据和分析平台的解决方案.但随着每天创建和收集的数据量都在增加,这使得使用传统技术进行数据分析成为一 ...

- 使用Apache Hudi + Amazon S3 + Amazon EMR + AWS DMS构建数据湖

1. 引入 数据湖使组织能够在更短的时间内利用多个源的数据,而不同角色用户可以以不同的方式协作和分析数据,从而实现更好.更快的决策.Amazon Simple Storage Service(amaz ...

- 恭喜!Apache Hudi社区新晋多位Committer

1. 介绍 经过Apache Hudi项目委员会讨论及投票,向Udit Mehrotra.Gary Li.Raymond Xu.Pratyaksh Sharma 4人发出Committer邀请,4人均 ...

- 使用Amazon EMR和Apache Hudi在S3上插入,更新,删除数据

将数据存储在Amazon S3中可带来很多好处,包括规模.可靠性.成本效率等方面.最重要的是,你可以利用Amazon EMR中的Apache Spark,Hive和Presto之类的开源工具来处理和分 ...

- 官宣!Amazon EMR正式支持Apache Hudi

Apache Hudi是一个开源的数据管理框架,其通过提供记录级别的insert, update, upsert和delete能力来简化增量数据处理和数据管道开发.Upsert指的是将记录插入到现有 ...

- 官宣!AWS Athena正式可查询Apache Hudi数据集

1. 引入 Apache Hudi是一个开源的增量数据处理框架,提供了行级insert.update.upsert.delete的细粒度处理能力(Upsert表示如果数据集中存在记录就更新:否则插入) ...

- Apache Hudi + AWS S3 + Athena实战

Apache Hudi在阿里巴巴集团.EMIS Health,LinkNovate,Tathastu.AI,腾讯,Uber内使用,并且由Amazon AWS EMR和Google云平台支持,最近Ama ...

- 基于 Apache Hudi + Presto + AWS S3 构建开放Lakehouse

认识Lakehouse 数据仓库被认为是对结构化数据执行分析的标准,但它不能处理非结构化数据. 包括诸如文本.图像.音频.视频和其他格式的信息. 此外机器学习和人工智能在业务的各个方面变得越来越普遍, ...

- 恭喜!Apache Hudi社区新晋两位Committer

1. 介绍 经过Apache Hudi项目委员会讨论及投票,向WangXiangHu和LiWei 2人发出Committer邀请,2人均已接受邀请并顺利成为Committer,也使得Apache Hu ...

随机推荐

- 2020 NGK 全球启动大会于美国硅谷圆满落幕

据NCC报道美国西海岸时间11月25日,NGK全球启动大会在美国加利福尼亚北部的硅谷会展中心成功举办.本次大会吸引了来自世界各地的企业家.创业者.开发者,以及投资人达一万人次齐聚硅谷. NGK创始人. ...

- Python数据结构与算法_最长公共前缀(05)

编写一个函数来查找字符串数组中的最长公共前缀. 如果不存在公共前缀,返回空字符串 "". 示例 1: 输入: ["flower","flow" ...

- epoll 原理

本文转载自epoll 原理 导语 以前经常被人问道 select.poll.epoll 的区别,基本都是靠死记硬背的,最近正好复习 linux 相关的内容,就把这一块做个笔记吧,以后也能方便查阅. e ...

- Mac电脑管理员密码丢失解决办法

1.重新启动电脑,并长按 Command (Win)+ S,并进入命令终端. 2.进入命令终端输入一下命令 /sbin/mount -uaw rm var/db/ .applesetupdone re ...

- 记一次Drone无法触发构建的问题

问题 好巧不巧,当你晚上准备上线的时候,在下午临近下班的时候CI&CD工具出问题了,提交代码不能触发构建,不能上线了,Drone平台那边也下班了,正好CICD依赖的公司git仓库也出问题了(就 ...

- mysql内一些可以报错注入的查询语句

一.exp() 取反参数 该函数简单来说就是,以e为底的对数,在当传递一个大于709的值时,函数exp()就会引起一个溢出错误,取反则可以导致很小的数值变得很大,比如说0 这样既可配合使用,e ...

- 如何在 ASP.Net Core 中使用 Lamar

ASP.Net Core 自带了一个极简的 开箱即用 的依赖注入容器,实际上,你还可以使用第三方的 依赖注入容器 来替代它,依赖注入是一种设计模式,它能够有效的实现对象之间的解耦并有利于提高单元测试和 ...

- python基础(9)增强型赋值与使用普通赋值的区别

前言 增强型赋值语句是经常被使用到的,因为从各种学习渠道中,我们能够得知i += 1的效率往往要比 i = i + 1 更高一些(这里以 += 为例,实际上增强型赋值语句不仅限于此).所以我们会乐此不 ...

- 【java框架】MyBatis(7)--MyBatis注解开发

1.MyBatis注解开发 1.1.Lombok的基本使用 Lombok是SpringBoot2.1.X版本与IDEA官方支持的一个插件,它是为简化POJO类中繁杂重复代码:geter/setter/ ...

- hessian简单介绍

Hessian是基于HTTP的轻量级远程服务解决方案,Hessian像Rmi一样,使用二进制消息进行客户端和服务器端交互.但与其他二进制远程调用技术(例如Rmi)不同的是,它的二进制消息可以移植其他非 ...