爬取豆瓣Top250图书数据

爬取豆瓣Top250图书数据

项目的实现步骤

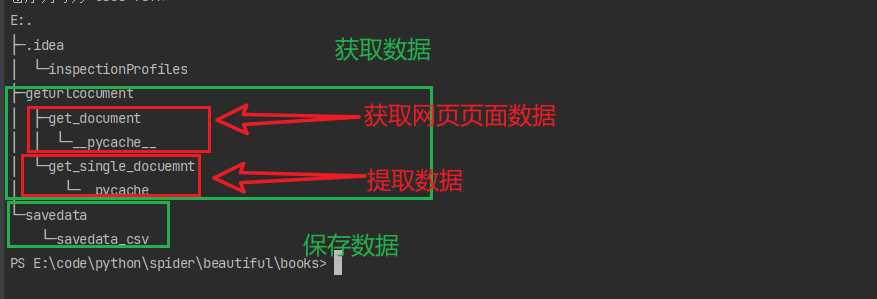

1.项目结构

2.获取网页数据

3.提取网页中的关键信息

4.保存数据

1.项目结构

2.获取网页数据

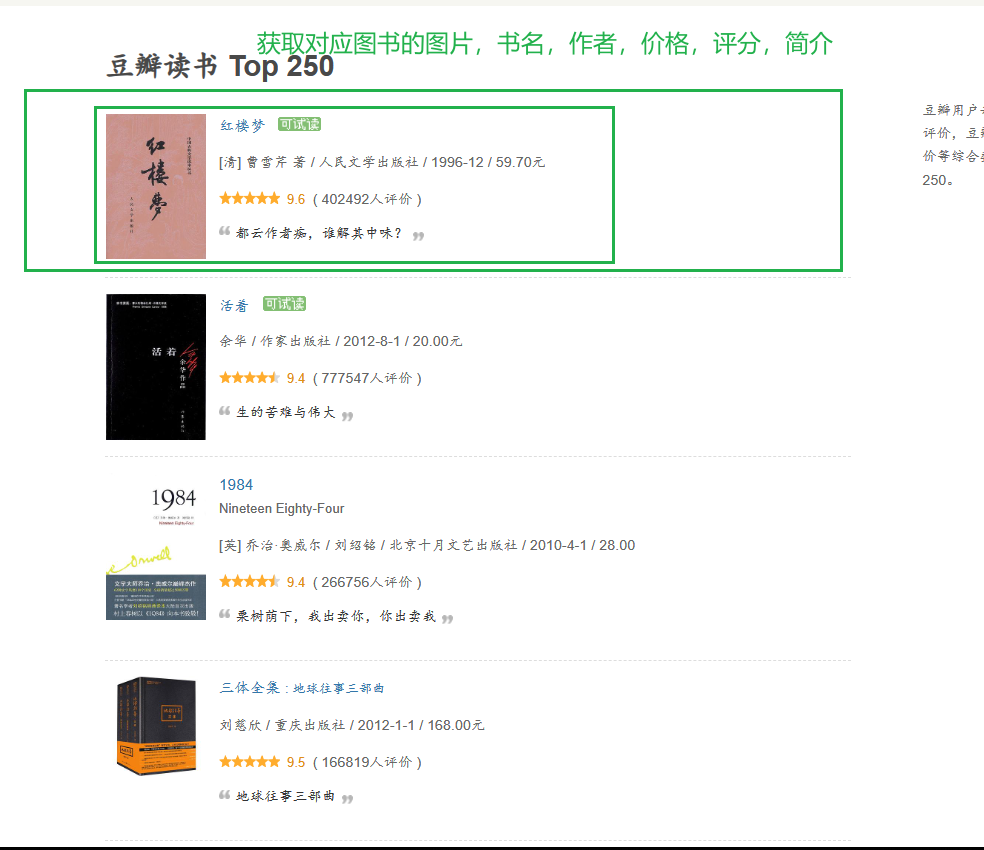

对应的网址为https://book.douban.com/top250

import requests

from bs4 import BeautifulSoup

"""

获取网页数据,解析数据,将相应的数据传出

"""

def get_page(url):

headers = {

'User-Agent':'Mozilla/5.0 (Linux; Android 6.0; Nexus 5 Build/MRA58N) '

'AppleWebKit/537.36 (KHTML, like Gecko) Chrome/114.0.0.0 '

'Mobile Safari/537.36 Edg/114.0.1823.43'

}

resp=requests.get(url,headers=headers)

soup=BeautifulSoup(resp.text,'html.parser')

return soup

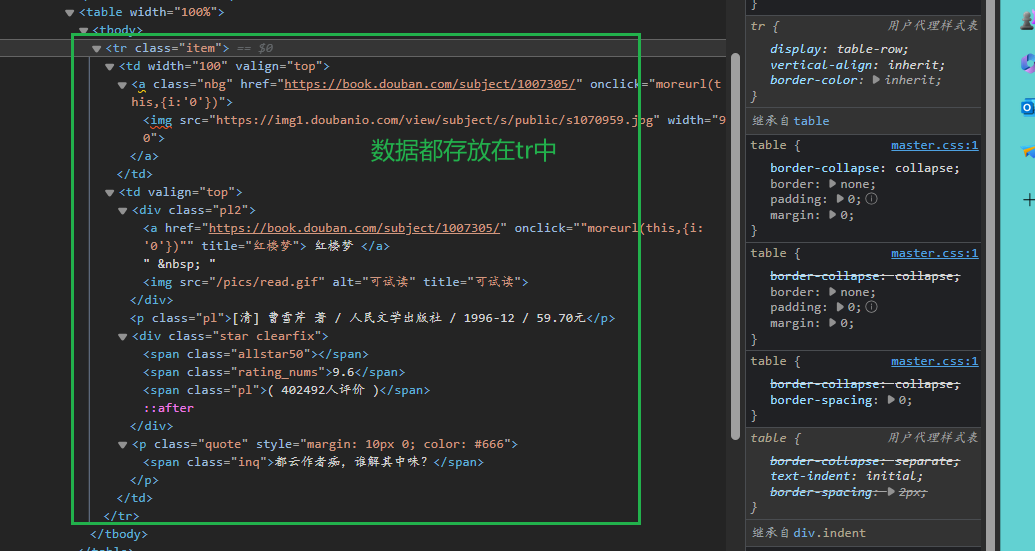

3.提取网页中的关键信息

获取传出的解析后的数据,获取对应的图片,书名,作者,价格,评价,简介

from geturlcocument.get_document import get_page

import re

# 初始数据

pictures=[]

names=[]

authors=[]

prices=[]

scores=[]

sums=[]

def get_single():

# 网址地址

urls = [f"https://book.douban.com/top250?start={num}" for num in range(0,250,25)]

for url in urls:

# 获取对应的网页文本

text = get_page.get_page(url)

# 所有数据的集合

all_tr = text.find_all(name="tr", attrs={"class": "item"})

# 查找每个单项

for tr in all_tr:

# 数据类型:图片,书名,作者,价格,评分,简介

# 图片

picture = tr.find(name="img")

picture = picture.get('src')

# print(picture)

# 书名

div = tr.find(name='div', attrs={'class': 'pl2'})

name = div.find('a').text

name = re.sub(r'\s+', '', name)

# 作者

author = tr.find(name='p', attrs={'class': 'pl'}).text

author = author.split('/')[0]

# 价格

price = author.split('/')[-1]

price = re.sub(r'元', '', price)

# 评分

score = tr.find(name='span', attrs={'class': 'rating_nums'}).text

try:

sum = tr.find(name='span', attrs={'class': 'inq'}).text

except AttributeError:

sum = ''

pictures.append(picture)

names.append(name)

authors.append(author)

prices.append(price)

scores.append(score)

sums.append(sum)

data = {

"picture": pictures,

"name": names,

"author": authors,

"price": prices,

"score": scores,

"sum": sums

}

return data

将获取的数据存入到字典中,将数据传出,使用re库对相应的数据进行处理,运用异常检错

4.保存数据

获取传出的字典类型的数据,将数据存入到pandas的DataFrame类型中

from geturlcocument.get_single_docuemnt import get_single

import pandas as pd

# 获取字典类型的数据

data=get_single.get_single()

# 用pandas的DataFrame类型存储数据

df=pd.DataFrame(data)

df.to_csv('./books.csv',encoding='utf-8')

print('ending of data')

该项目完成!!!

爬取豆瓣Top250图书数据的更多相关文章

- 基础爬虫,谁学谁会,用requests、正则表达式爬取豆瓣Top250电影数据!

爬取豆瓣Top250电影的评分.海报.影评等数据! 本项目是爬虫中最基础的,最简单的一例: 后面会有利用爬虫框架来完成更高级.自动化的爬虫程序. 此项目过程是运用requests请求库来获取h ...

- 爬取豆瓣网图书TOP250的信息

爬取豆瓣网图书TOP250的信息,需要爬取的信息包括:书名.书本的链接.作者.出版社和出版时间.书本的价格.评分和评价,并把爬取到的数据存储到本地文件中. 参考网址:https://book.doub ...

- 正则爬取豆瓣Top250数据存储到CSV文件(6行代码)

利用正则爬取豆瓣TOP250电影信息 电影名字 电影年份 电影评分 评论人数 import requests import csv import re # 不算导包的话正式代码6行 存储到csv文件 ...

- requests爬取豆瓣top250电影信息

''' 1.爬取豆瓣top250电影信息 - 第一页: https://movie.douban.com/top250?start=0&filter= - 第二页: https://movie ...

- python爬取豆瓣电影信息数据

题外话+ 大家好啊,最近自己在做一个属于自己的博客网站(准备辞职回家养老了,明年再战)在家里 琐事也很多, 加上自己 一回到家就懒了(主要是家里冷啊! 广东十几度,老家几度,躲在被窝瑟瑟发抖,) 由于 ...

- Python 爬取豆瓣TOP250实战

学习爬虫之路,必经的一个小项目就是爬取豆瓣的TOP250了,首先我们进入TOP250的界面看看. 可以看到每部电影都有比较全面的简介.其中包括电影名.导演.评分等. 接下来,我们就爬取这些数据,并将这 ...

- Python-爬虫实战 简单爬取豆瓣top250电影保存到本地

爬虫原理 发送数据 获取数据 解析数据 保存数据 requests请求库 res = requests.get(url="目标网站地址") 获取二进制流方法:res.content ...

- re、base64的结合使用爬取豆瓣top250

一.缘由 对于豆瓣的这个网站,记得使用了不少于三种的爬取和解析方式来进行的.今天的这种解析方式是我使用起来较为顺手,后来就更喜欢使用xpath解析,但是这两种也需要掌握. 二.代码展示 '''爬取豆瓣 ...

- Python爬虫实例:爬取豆瓣Top250

入门第一个爬虫一般都是爬这个,实在是太简单.用了 requests 和 bs4 库. 1.检查网页元素,提取所需要的信息并保存.这个用 bs4 就可以,前面的文章中已经有详细的用法阐述. 2.找到下一 ...

- Python爬虫爬取豆瓣电影之数据提取值xpath和lxml模块

工具:Python 3.6.5.PyCharm开发工具.Windows 10 操作系统.谷歌浏览器 目的:爬取豆瓣电影排行榜中电影的title.链接地址.图片.评价人数.评分等 网址:https:// ...

随机推荐

- 游戏模拟——Position based dynamics

目录 Verlet积分 基本积分方法 Verlet 算位置 Verlet 算速度 PBD 基于力的方法解碰撞 过冲问题 基于位置的方法解碰撞 算法流程 求解器借用的思想 关于动量守恒 约束投影 简单约 ...

- python之操作注册表

与注册表操作相关的函数可以分为打开注册表.关闭注册表.读取项值.c添加项值.添加项,以及删除项等几类. 描述 HKEY_CLASSES_ROOT,是HKEY_LOCAL_MACHINE\Softwar ...

- [Linux]Xmanager+Xshell远程管理桌面版CentOS物理服务器的桌面版CentOS虚拟机

1 需求/背景 在项目现场有这么一个情况,有1台Gnome版的CentOS的物理服务器,其内运行了2台通过vmware安装的Gnome桌面版的CentOS的虚拟服务器. 按照常规做法是: 将唯一的1台 ...

- 从零开始学Vue(二~三)—— Vue 实例 / 模板语法(插值、指令)

概述 vue.js作为现在笔记热门的JS框架,使用比较简单易上手,也成为很多公司首选的JS框架. 但是对于初学者可能学起来有些麻烦,所以推出<从零开始学Vue>系列博客,本系列计划推出19 ...

- 从ajax到跨域引发的相关面试题总结

转载请注明出处: 1.ajax异步和同步的区别 Ajax是一种基于JavaScript语言和XMLHttpRequest对象的异步数据传输技术,通过它可以使不用刷新整个页面的情况下,对页面进行部分更新 ...

- 在有限 computational budget 下,借助 low-fidelity 模型提高精度

论文名称:context-aware learning of hierarchies of low-fidelity models for multi-fidelity uncertainty qua ...

- 连接MongoDB+Docker安装MongoDB

一.连接MongoDB 工具:studio 3T 下载:https://studio3t.com/download-thank-you/?OS=win64 1.无设置密码 最终成功页面 2.设置了密码 ...

- TEMP_FAILURE_RETRY宏的用法

#define TEMP_FAILURE_RETRY(expression) \ (__extension__\ ({ long int __result;\ do ...

- 2021牛客OI赛前集训营-提高组(第二场)第三题 树数树题解

题目描述 牛牛有一棵 \(n\) 个点的有根树,根为 \(1\). 我们称一个长度为 \(m\) 的序列 \(a\) 是好的,当且仅当: \(\forall i \in (1,m]\),\(a_i\) ...

- 通过Handsontable实现像Excel一样编辑数据

一.Handsontable是指什么? 官网: http://handsontable.com Handsontable是一个JavaScript库,可以帮助您轻松实现类似Excel电子表格一样的编 ...