python爬虫scrapy的LinkExtractor

使用背景:

我们通常在爬去某个网站的时候都是爬去每个标签下的某些内容,往往一个网站的主页后面会包含很多物品或者信息的详细的内容,我们只提取某个大标签下的某些内容的话,会显的效率较低,大部分网站的都是按照固定套路(也就是固定模板,把各种信息展示给用户),LinkExtrator就非常适合整站抓取,为什么呢?因为你通过xpath、css等一些列参数设置,拿到整个网站的你想要的链接,而不是固定的某个标签下的一些链接内容,非常适合整站爬取。

import scrapy

from scrapy.linkextractor import LinkExtractor class WeidsSpider(scrapy.Spider):

name = "weids"

allowed_domains = ["wds.modian.com"]

start_urls = ['http://www.gaosiedu.com/gsschool/'] def parse(self, response):

link = LinkExtractor(restrict_xpaths='//ul[@class="cont_xiaoqu"]/li')

links = link.extract_links(response)

print(links)

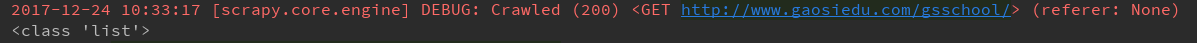

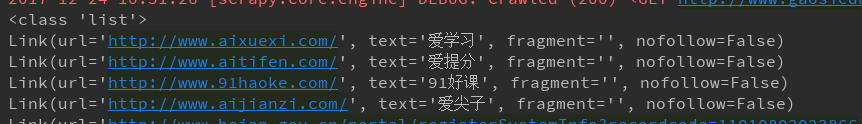

links是一个list

我们来迭代一下这个list

for link in links:

print(link)

links里面包含了我们要提取的url,那我们怎么才能拿到这个url呢?

直接在for循环里面link.url就能拿到我们要的url和text信息

for link in links:

print(link.url,link.text)

别着急,LinkExtrator里面不止一个xpath提取方法,还有很多参数。

>allow:接收一个正则表达式或一个正则表达式列表,提取绝对url于正则表达式匹配的链接,如果该参数为空,默认全部提取。

# -*- coding: utf-8 -*-

import scrapy

from scrapy.linkextractor import LinkExtractor class WeidsSpider(scrapy.Spider):

name = "weids"

allowed_domains = ["wds.modian.com"]

start_urls = ['http://www.gaosiedu.com/gsschool/'] def parse(self, response):

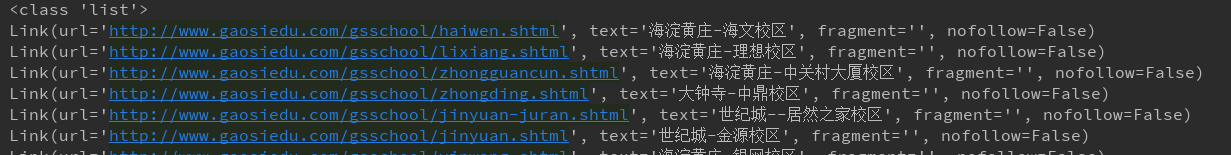

pattern = '/gsschool/.+\.shtml'

link = LinkExtractor(allow=pattern)

links = link.extract_links(response)

print(type(links))

for link in links:

print(link)

>deny:接收一个正则表达式或一个正则表达式列表,与allow相反,排除绝对url于正则表达式匹配的链接,换句话说,就是凡是跟正则表达式能匹配上的全部不提取。

# -*- coding: utf-8 -*-

import scrapy

from scrapy.linkextractor import LinkExtractor class WeidsSpider(scrapy.Spider):

name = "weids"

allowed_domains = ["wds.modian.com"]

start_urls = ['http://www.gaosiedu.com/gsschool/'] def parse(self, response):

pattern = '/gsschool/.+\.shtml'

link = LinkExtractor(deny=pattern)

links = link.extract_links(response)

print(type(links))

for link in links:

print(link)

>allow_domains:接收一个域名或一个域名列表,提取到指定域的链接。

# -*- coding: utf-8 -*-

import scrapy

from scrapy.linkextractor import LinkExtractor class WeidsSpider(scrapy.Spider):

name = "weids"

allowed_domains = ["wds.modian.com"]

start_urls = ['http://www.gaosiedu.com/gsschool/'] def parse(self, response):

domain = ['gaosivip.com','gaosiedu.com']

link = LinkExtractor(allow_domains=domain)

links = link.extract_links(response)

print(type(links))

for link in links:

print(link)

>deny_domains:和allow_doains相反,拒绝一个域名或一个域名列表,提取除被deny掉的所有匹配url。

# -*- coding: utf-8 -*-

import scrapy

from scrapy.linkextractor import LinkExtractor class WeidsSpider(scrapy.Spider):

name = "weids"

allowed_domains = ["wds.modian.com"]

start_urls = ['http://www.gaosiedu.com/gsschool/'] def parse(self, response):

domain = ['gaosivip.com','gaosiedu.com']

link = LinkExtractor(deny_domains=domain)

links = link.extract_links(response)

print(type(links))

for link in links:

print(link)

>restrict_xpaths:我们在最开始做那个那个例子,接收一个xpath表达式或一个xpath表达式列表,提取xpath表达式选中区域下的链接。

>restrict_css:这参数和restrict_xpaths参数经常能用到,所以同学必须掌握,个人更喜欢xpath。

# -*- coding: utf-8 -*-

import scrapy

from scrapy.linkextractor import LinkExtractor class WeidsSpider(scrapy.Spider):

name = "weids"

allowed_domains = ["wds.modian.com"]

start_urls = ['http://www.gaosiedu.com/gsschool/'] def parse(self, response):

link = LinkExtractor(restrict_css='ul.cont_xiaoqu > li')

links = link.extract_links(response)

print(type(links))

for link in links:

print(link)

>tags:接收一个标签(字符串)或一个标签列表,提取指定标签内的链接,默认为tags=(‘a’,‘area’)

>attrs:接收一个属性(字符串)或者一个属性列表,提取指定的属性内的链接,默认为attrs=(‘href’,),示例,按照这个中提取方法的话,这个页面上的某些标签的属性都会被提取出来,如下例所示,这个页面的a标签的href属性值都被提取到了。

# -*- coding: utf-8 -*-

import scrapy

from scrapy.linkextractor import LinkExtractor class WeidsSpider(scrapy.Spider):

name = "weids"

allowed_domains = ["wds.modian.com"]

start_urls = ['http://www.gaosiedu.com/gsschool/'] def parse(self, response):

link = LinkExtractor(tags='a',attrs='href')

links = link.extract_links(response)

print(type(links))

for link in links:

print(link)

前面我们讲了这么多LinkExtractor的基本用法,上面的只是为了快速试验,真正的基本用法是结合Crawler和Rule,代码如下

# -*- coding: utf-8 -*-

import scrapy

from scrapy.linkextractor import LinkExtractor

from scrapy.spiders.crawl import CrawlSpider,Rule class GaosieduSpider(CrawlSpider):

name = "gaosiedu"

allowed_domains = ["www.gaosiedu.com"]

start_urls = ['http://www.gaosiedu.com/']

restrict_xpath = '//ul[@class="schoolList clearfix"]'

allow = '/gsschool/.+\.shtml'

rules = {

Rule(LinkExtractor(restrict_xpaths=restrict_xpath), callback="parse_item", follow=True)

} def parse_item(self,response):

schooll_name = response.xpath('//div[@class="area_nav"]//h3/text()').extract_first()

print(schooll_name)

简单的说一下,上面我们本应该继承scrapy.Spider类,这里需要继承CrawlSpider类(因为CrawlSpider类也是继承了scrapy.Spider类),rules是基本写法,可不是随便哪个单词都可以的啊,而且注意rules必须是一个list或者dict,如果是tuple的话就会报错。里面的话Rule里面包含了几个参数,LinkExtractor就不在这里熬述了,看上面就行,至于其他的几个参数,可以看我们另外一篇博文:http://www.cnblogs.com/lei0213/p/7976280.html

python爬虫scrapy的LinkExtractor的更多相关文章

- python爬虫scrapy框架——人工识别登录知乎倒立文字验证码和数字英文验证码(2)

操作环境:python3 在上一文中python爬虫scrapy框架--人工识别知乎登录知乎倒立文字验证码和数字英文验证码(1)我们已经介绍了用Requests库来登录知乎,本文如果看不懂可以先看之前 ...

- python爬虫Scrapy(一)-我爬了boss数据

一.概述 学习python有一段时间了,最近了解了下Python的入门爬虫框架Scrapy,参考了文章Python爬虫框架Scrapy入门.本篇文章属于初学经验记录,比较简单,适合刚学习爬虫的小伙伴. ...

- python爬虫scrapy项目详解(关注、持续更新)

python爬虫scrapy项目(一) 爬取目标:腾讯招聘网站(起始url:https://hr.tencent.com/position.php?keywords=&tid=0&st ...

- python爬虫scrapy框架

Scrapy 框架 关注公众号"轻松学编程"了解更多. 一.简介 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量 ...

- Python爬虫Scrapy框架入门(0)

想学习爬虫,又想了解python语言,有个python高手推荐我看看scrapy. scrapy是一个python爬虫框架,据说很灵活,网上介绍该框架的信息很多,此处不再赘述.专心记录我自己遇到的问题 ...

- [Python爬虫] scrapy爬虫系列 <一>.安装及入门介绍

前面介绍了很多Selenium基于自动测试的Python爬虫程序,主要利用它的xpath语句,通过分析网页DOM树结构进行爬取内容,同时可以结合Phantomjs模拟浏览器进行鼠标或键盘操作.但是,更 ...

- 安装python爬虫scrapy踩过的那些坑和编程外的思考

这些天应朋友的要求抓取某个论坛帖子的信息,网上搜索了一下开源的爬虫资料,看了许多对于开源爬虫的比较发现开源爬虫scrapy比较好用.但是以前一直用的java和php,对python不熟悉,于是花一天时 ...

- Python 爬虫-Scrapy爬虫框架

2017-07-29 17:50:29 Scrapy是一个快速功能强大的网络爬虫框架. Scrapy不是一个函数功能库,而是一个爬虫框架.爬虫框架是实现爬虫功能的一个软件结构和功能组件集合.爬虫框架是 ...

- python爬虫scrapy学习之篇二

继上篇<python之urllib2简单解析HTML页面>之后学习使用Python比较有名的爬虫scrapy.网上搜到两篇相应的文档,一篇是较早版本的中文文档Scrapy 0.24 文档, ...

随机推荐

- 基于位置的服务——百度地图SDK练习

基于位置的服务所围绕的核心就是要先确定出用户所在的位置.通常有两种技术方式可以实现:一种是通过GPS定位,一种是通过网络定位.Android对这两种定位方式都提供了相应的API支持.但由于众所周知的原 ...

- WPF中控件的显示与隐藏

1.WPF中控件的显示与隐藏的属性是 Visibility,它有3个枚举值 Visible, Hidden 和 Collapsed.其中Visible为可见,而 Hidden 和 Collapsed ...

- 监控和管理Oracle UNDO表空间的使用

对Oracle数据库UNDO表空间的监控和管理是我们日常最重要的工作之一,UNDO表空间通常都是Oracle自动化管理(通过undo_management初始化参数确定):UNDO表空间是用于存储DM ...

- mac 下利用AndroidStudio APK获取签名信息

注:网上没找到特别好的.不是xxx.keystore 就是debug.keystore 而真正去找这些目录的时候系统就会提示没有这个秘钥库文件.所以就悲剧了 下面附上快速查看APK签名信息的方法(SH ...

- 一:Neutron实现网络虚拟化

一 云计算时代数据中心物理网络的问题 数据中心虚拟化成为了趋势,最典型的场景莫过于:对数据中心的服务器进行虚拟化,来提高资源利用率,同时降低单位能耗. 但是,随着数据中心虚拟化程度的不断提高.虚拟化服 ...

- Vue-插槽学习

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8&quo ...

- Android so注入(inject)和Hook技术学习(一)

以前对Android so的注入只是通过现有的框架,并没有去研究so注入原理,趁现在有时间正好拿出来研究一下. 首先来看注入流程.Android so的注入流程如下: attach到远程进程 -> ...

- UIImageView - BNR

继续上节UINavigationController - BNR. 打开BNRDetailViewController.xib文件,向view中添加UIImageView对象,选中该对象,通过Attr ...

- Groovy语言学习--语法基础(2)

集合和闭包 因为之前没接触过C++等,对指针也一窍不通.个人不成熟的了解 闭包是一种数据类型,可以很方便的执行一段独立的代码 简化方法的调用 package groovy /** * Groovy容器 ...

- mskitten

简介 一个普普通通的Java程序员,在某制造业外企工作. 技术栈 主要是Core Java,准备向Java Web挺进. 非计算机专业学生,在努力提升计算机基本素养(操作系统.算法).有好书好资源欢迎 ...