第三百六十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理

第三百六十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理

1、映射(mapping)介绍

映射:创建索引的时候,可以预先定义字段的类型以及相关属性

elasticsearch会根据json源数据的基础类型猜测你想要的字段映射,将输入的数据转换成可搜索的索引项,mapping就是我们自己定义的字段数据类型,同时告诉elasticsearch如何索引数据以及是否可以被搜索

作用:会让索引建立的更加细致和完善

类型:静态映射和动态映射

2、内置映射类型(也就是数据类型)

string类型:text,keyword两种

text类型:会进行分词,抽取词干,建立倒排索引

keyword类型:就是一个普通字符串,只能完全匹配才能搜索到

数字类型:long,integer,short,byte,double,float

日期类型:date

bool(布尔)类型:boolean

binary(二进制)类型:binary

复杂类型:object,nested

geo(地区)类型:geo-point,geo-shape

专业类型:ip,competion

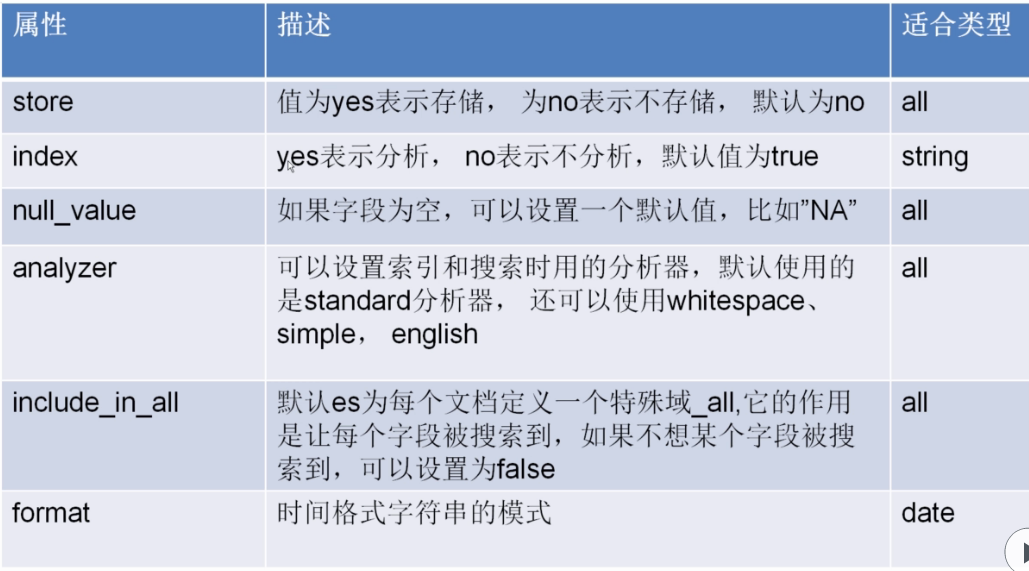

3、属性介绍

store属性

index属性

null_value属性

analyzer属性

include_in_all属性

format属性

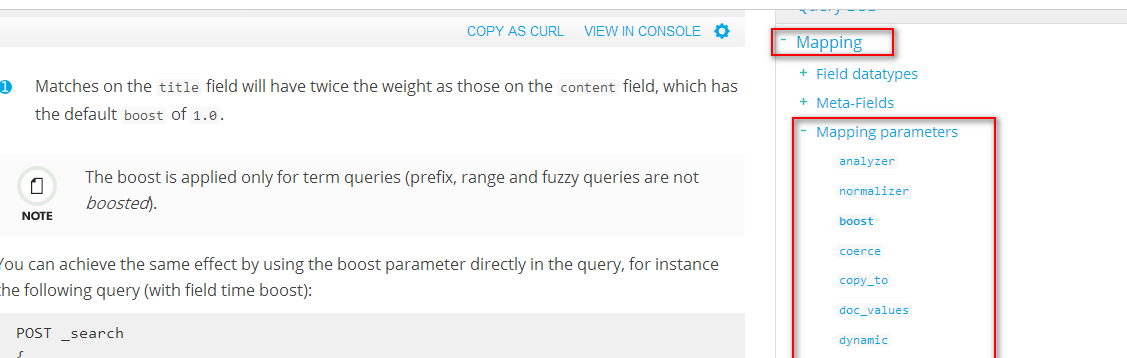

更多属性:https://www.elastic.co/guide/en/elasticsearch/reference/current/mapping-boost.html

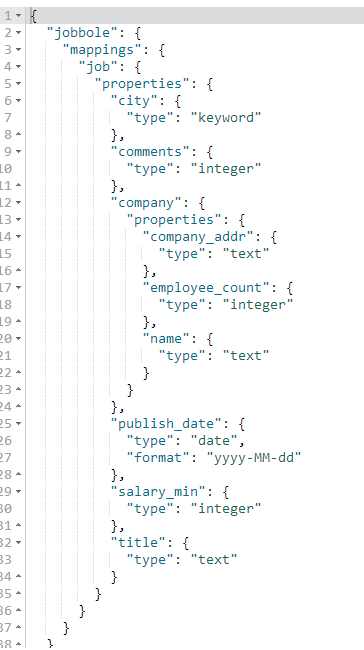

4、创建索引(相当于创建数据库)、创建表、创建字段-设置字段类型,添加数据

说明:

#创建索引(设置字段类型)

PUT jobbole #创建索引设置索引名称

{

"mappings": { #设置mappings映射字段类型

"job": { #表名称

"properties": { #设置字段类型

"title":{ #title字段

"type": "text" #text类型,text类型可以分词,建立倒排索引

},

"salary_min":{ #salary_min字段

"type": "integer" #integer数字类型

},

"city":{ #city字段

"type": "keyword" #keyword普通字符串类型

},

"company":{ #company字段,是嵌套字段

"properties":{ #设置嵌套字段类型

"name":{ #name字段

"type":"text" #text类型

},

"company_addr":{ #company_addr字段

"type":"text" #text类型

},

"employee_count":{ #employee_count字段

"type":"integer" #integer数字类型

}

}

},

"publish_date":{ #publish_date字段

"type": "date", #date时间类型

"format":"yyyy-MM-dd" #yyyy-MM-dd格式化时间样式

},

"comments":{ #comments字段

"type": "integer" #integer数字类型

}

}

}

}

} #保存文档(相当于数据库的写入数据)

PUT jobbole/job/1 #索引名称/表/id

{

"title":"python分布式爬虫开发", #字段名称:字段值

"salary_min":15000, #字段名称:字段值

"city":"北京", #字段名称:字段值

"company":{ #嵌套字段

"name":"百度", #字段名称:字段值

"company_addr":"北京市软件园", #字段名称:字段值

"employee_count":50 #字段名称:字段值

},

"publish_date":"2017-4-16", #字段名称:字段值

"comments":15 #字段名称:字段值

}

代码:

#创建索引(设置字段类型)

PUT jobbole

{

"mappings": {

"job": {

"properties": {

"title":{

"type": "text"

},

"salary_min":{

"type": "integer"

},

"city":{

"type": "keyword"

},

"company":{

"properties":{

"name":{

"type":"text"

},

"company_addr":{

"type":"text"

},

"employee_count":{

"type":"integer"

}

}

},

"publish_date":{

"type": "date",

"format":"yyyy-MM-dd"

},

"comments":{

"type": "integer"

}

}

}

}

} #保存文档(相当于数据库的写入数据)

PUT jobbole/job/1

{

"title":"python分布式爬虫开发",

"salary_min":15000,

"city":"北京",

"company":{

"name":"百度",

"company_addr":"北京市软件园",

"employee_count":50

},

"publish_date":"2017-4-16",

"comments":15

}

5、获取索引下的mappings映射字段类型

#获取一个索引下的所有表的mappings映射字段类型

GET jobbole/_mapping

#获取一个索引下的指定表的mappings映射字段类型

GET jobbole/_mapping/job

【重点】在创建索引时一旦给字段设置了类型后就不可修改了,如果必须要修改就的重新创建索引,所以在创建索引时就必须确定好字段类型

第三百六十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理的更多相关文章

- 第三百六十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索的自动补全功能

第三百六十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—用Django实现搜索的自动补全功能 elasticsearch(搜索引擎)提供了自动补全接口 官方说明:https://www.e ...

- 第三百六十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mget和bulk批量操作

第三百六十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mget和bulk批量操作 注意:前面讲到的各种操作都是一次http请求操作一条数据,如果想 ...

- 第三百五十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—将bloomfilter(布隆过滤器)集成到scrapy-redis中

第三百五十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—将bloomfilter(布隆过滤器)集成到scrapy-redis中,判断URL是否重复 布隆过滤器(Bloom Filter)详 ...

- 第三百五十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy的暂停与重启

第三百五十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy的暂停与重启 scrapy的每一个爬虫,暂停时可以记录暂停状态以及爬取了哪些url,重启时可以从暂停状态开始爬取过的UR ...

- 第三百六十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索功能

第三百六十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索功能 Django实现搜索功能 1.在Django配置搜索结果页的路由映 ...

- 第三百六十六节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的bool组合查询

第三百六十六节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的bool组合查询 bool查询说明 filter:[],字段的过滤,不参与打分must:[] ...

- 第三百六十五节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本查询

第三百六十五节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本查询 1.elasticsearch(搜索引擎)的查询 elasticsearch是功能 ...

- 第三百六十节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本概念

第三百六十节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本概念 elasticsearch的基本概念 1.集群:一个或者多个节点组织在一起 2.节点 ...

- 第三百六十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)scrapy写入数据到elasticsearch中

第三百六十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)scrapy写入数据到elasticsearch中 前面我们讲到的elasticsearch( ...

随机推荐

- 【Android】ADB常用指令与logcat日志

ADB命令简介 ADB是一个功能强大的命令行工具.通过它可以直接和模拟器或真机进行交互.它是一个具有客户端和服务器端的程序. 它主要由三个部分组成: 客户端,它运行在你的开发机上,你可以通过执行adb ...

- MyBatis教程目录

MyBatis教程目录 2017-10-18 摘自 YSOcean MyBatis教程目录: 1 mybatis 详解(一)------JDBC 2 mybatis 详解(二)------入门实例( ...

- 【Ubuntu】查看GPU状态

watch -n 10 nvidia-smi TensorFlow指定GPU CUDA_DEVICE_ORDER="PCI_BUS_ID" CUDA_VISIBLE_DEVICES ...

- 【Java】异常类处理层次

异常处理简介 异常在java的开发中可能没有那么被重视.一般遇到异常,直接上抛,或者随便catch一下处理之后对于程序整体运行也没有什么大的影响.不过在企业级设计开发中,异常的设计与处理的好坏,往往就 ...

- Redis之 命令行 操作

一.key pattern 查询相应的key (1)redis允许模糊查询key 有3个通配符 *.?.[] (2)randomkey:返回随机key (3)type key:返回key存储的类型 ...

- 【C++程序员学 python】python 的文件类型

python的文件类型主要分为3种,分别是源代码.字节代码和优化代码.这些代码都可以直接运行,不需要进行编译或者连接.这正是python语言的特性,python的文件通过python.exe 或pyt ...

- Joint Extraction of Entities and Relations论文解析

1. 前言 实体和关系的联合抽取问题作为信息抽取的关键任务,其实现方法可以简单分为两类: 一类是串联抽取方法.传统的串联抽取就是首先进行实体抽取,然后进行关系识别.这种分开的方法比较容易实现,而且各个 ...

- ssh 地址

structs2http://struts.apache.org/download.cgi spring hibernate http://hibernate.org/orm/downloads/

- 实验吧 web题writeup

1.http://ctf5.shiyanbar.com/web/wonderkun/web/index.html 用户名我输入:or'xor"and"select"uni ...

- PHPUnit 手册(转)

PHPUnit 手册 PHPUnit 手册 Sebastian Bergmann 版权 © 2005, 2006, 2007, 2008, 2009, 2010, 2011, 2012, 2013, ...