HUE配置文件hue.ini 的filebrowser模块详解(图文详解)(分HA集群和非HA集群)

不多说,直接上干货!

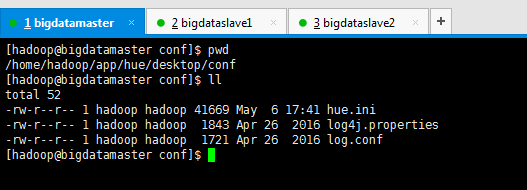

我的集群机器情况是 bigdatamaster(192.168.80.10)、bigdataslave1(192.168.80.11)和bigdataslave2(192.168.80.12)

然后,安装目录是在/home/hadoop/app下。

官方建议在master机器上安装Hue,我这里也不例外。安装在bigdatamaster机器上。

- Hue版本:hue-3.9.0-cdh5.5.4

- 需要编译才能使用(联网)

- 说给大家的话:大家电脑的配置好的话,一定要安装cloudera manager。毕竟是一家人的。

同时,我也亲身经历过,会有部分组件版本出现问题安装起来要个大半天时间去排除,做好心里准备。废话不多说,因为我目前读研,自己笔记本电脑最大8G,只能玩手动来练手。

纯粹是为了给身边没高配且条件有限的学生党看的! 但我已经在实验室机器群里搭建好cloudera manager 以及 ambari都有。

大数据领域两大最主流集群管理工具Ambari和Cloudera Manger

Cloudera安装搭建部署大数据集群(图文分五大步详解)(博主强烈推荐)

Ambari安装搭建部署大数据集群(图文分五大步详解)(博主强烈推荐)

Hue提供了图形化截面管理HDFS数据,可谓之非常方便,但是在配置上,还是有点麻烦的。

说明:对于这个filebrowser模块啊,网上有些资料是对pseudo-distributed.ini进行配置,也有些资料对hue.ini进行配置。其实本质都是一样哈!

有些Hue的版本里是没有前者。比如我的版本是直接下载hue-3.9.0-cdh5.5.4.tar.gz,然后进行编译得到。

这个问题没事。只需要对其中一个配置文件进行修改即可。

一、以下是默认的配置文件

二、以下是跟我机器集群匹配的配置文件(非HA集群下怎么配置Hue的filebrowser模块)

也就说,非HA集群的话,仅需要配置WebHdfs

即,即要在$HADOOP_HOME/etc/hadoop下,配置好hdfs-site.xml 和 core-site.xml

在core-site.xml 和 hdfs-site.xml下,添加如下

core-site.xml下

- <property>

- <name>hadoop.proxyuser.hue.hosts</name>

- <value>*</value>

- </property>

- <property>

- <name>hadoop.proxyuser.hue.groups</name>

- <value>*</value>

- </property>

hdfs-site.xml下

- <property>

- <name>dfs.webhdfs.enabled</name>

- <value>true</value>

- </property>

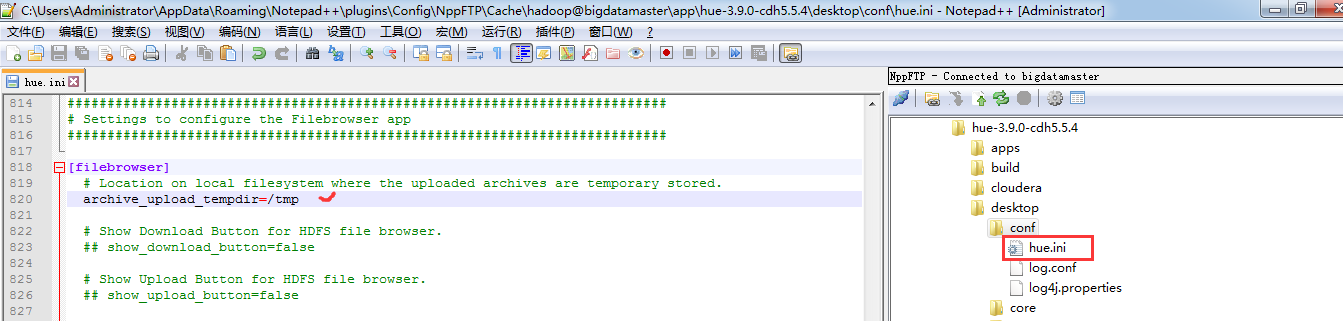

- [filebrowser]模块总的是如下

- ###########################################################################

- # Settings to configure the Filebrowser app

- ###########################################################################

- [filebrowser]

- # Location on local filesystem where the uploaded archives are temporary stored.

- archive_upload_tempdir=/tmp

- # Show Download Button for HDFS file browser.

- ## show_download_button=false

- # Show Upload Button for HDFS file browser.

- ## show_upload_button=false

三、以下是跟我机器集群匹配的配置文件(HA集群下怎么配置Hue的filebrowser模块)

也就说,HA集群的话,不仅需要配置WebHdfs,还要配置httpfs。

即,即要在$HADOOP_HOME/etc/hadoop下,配置好hdfs-site.xml 和 core-site.xml,还要配置好 httpfs-site.xml 。

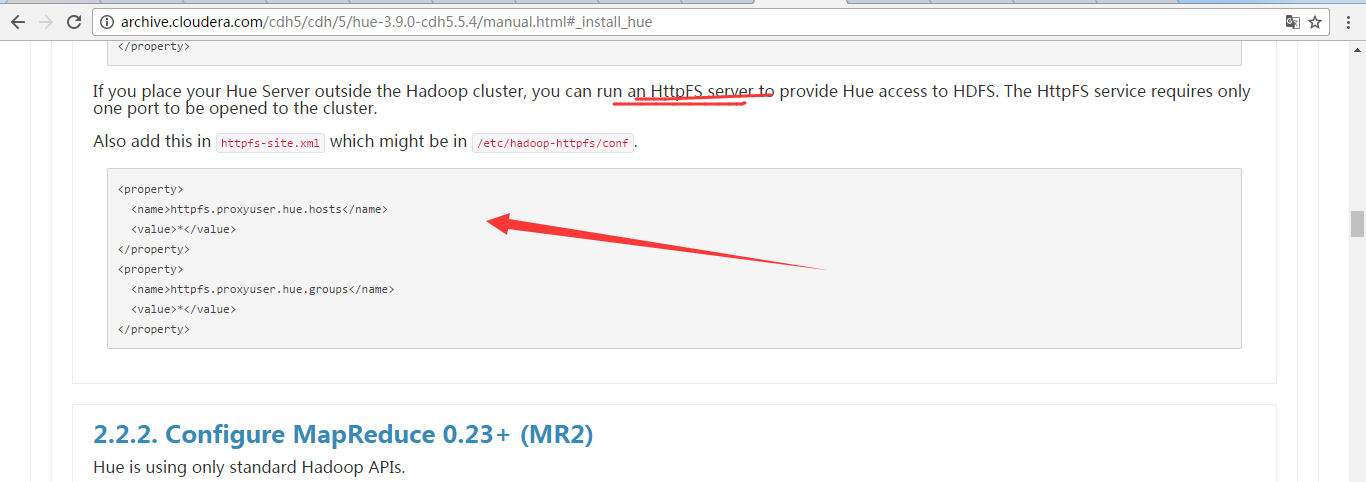

注意,在hdfs_clusters模块里,若要配置HA的话,则必须是要用到HttpFs。请看Hue的官网配置例子

- http://archive.cloudera.com/cdh5/cdh/5/hue-3.9.0-cdh5.5.4/manual.html#_install_hue

注意: 在$HADOOP_HOME/etc/hadoop/下的httpfs-site.xml。(djt11、djt12、djt12、djt14和djt15都需要配置)

先配置好如下

- <property>

- <name>httpfs.proxyuser.hue.hosts</name>

- <value>*</value>

- </property>

- <property>

- <name>httpfs.proxyuser.hue.groups</name>

- <value>*</value>

- </property>

同时,还要配置WebHdfs,别忘记啦!

在core-site.xml 和 hdfs-site.xml下,添加如下

core-site.xml下

- <property>

- <name>hadoop.proxyuser.hue.hosts</name>

- <value>*</value>

- </property>

- <property>

- <name>hadoop.proxyuser.hue.groups</name>

- <value>*</value>

- </property>

hdfs-site.xml下

- <property>

- <name>dfs.webhdfs.enabled</name>

- <value>true</value>

- </property>

然后,配置

- [filebrowser]模块总的是如下

- ###########################################################################

- # Settings to configure the Filebrowser app

- ###########################################################################

- [filebrowser]

- # Location on local filesystem where the uploaded archives are temporary stored.

- archive_upload_tempdir=/tmp

- # Show Download Button for HDFS file browser.

- ## show_download_button=false

- # Show Upload Button for HDFS file browser.

- ## show_upload_button=false

同时,大家可以关注我的个人博客:

http://www.cnblogs.com/zlslch/ 和 http://www.cnblogs.com/lchzls/ http://www.cnblogs.com/sunnyDream/

详情请见:http://www.cnblogs.com/zlslch/p/7473861.html

人生苦短,我愿分享。本公众号将秉持活到老学到老学习无休止的交流分享开源精神,汇聚于互联网和个人学习工作的精华干货知识,一切来于互联网,反馈回互联网。

目前研究领域:大数据、机器学习、深度学习、人工智能、数据挖掘、数据分析。 语言涉及:Java、Scala、Python、Shell、Linux等 。同时还涉及平常所使用的手机、电脑和互联网上的使用技巧、问题和实用软件。 只要你一直关注和呆在群里,每天必须有收获

对应本平台的讨论和答疑QQ群:大数据和人工智能躺过的坑(总群)(161156071)

HUE配置文件hue.ini 的filebrowser模块详解(图文详解)(分HA集群和非HA集群)的更多相关文章

- HUE配置文件hue.ini 的hdfs_clusters模块详解(图文详解)(分HA集群和非HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的yarn_clusters模块详解(图文详解)(分HA集群和非HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的hbase模块详解(图文详解)(分HA集群和非HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的Spark模块详解(图文详解)(分HA集群和HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的impala模块详解(图文详解)(分HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的hive和beeswax模块详解(图文详解)(分HA集群和非HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的zookeeper模块详解(图文详解)(分HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的pig模块详解(图文详解)(分HA集群和非HA集群)

不多说,直接上干货! 一.默认的pig配置文件 ########################################################################### ...

- HUE配置文件hue.ini 的liboozie和oozie模块详解(图文详解)(分HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

随机推荐

- 【Python】包管理工具pip

一.pip的安装 1. 将"D:\Python27\" 和 "D:\Python27\Scripts"设置到环境变量当中 2. 安装setup tools 将 ...

- python常见操作的模板

1.生成要求稀疏度的随机矩阵 import scipy import scipy.sparse import numpy n=10 m=10 density=0.5 matrixformat='coo ...

- ocrsearch的横屏转竖屏的解决方案

//这是其中解决预览图的一部分(坑了好久的)@Override public void onPreviewFrame(byte[] data, Camera camera) { Size previe ...

- fileOP

public void getFileDir(String filePath) { try{ this.tv.setText("当前路径:"+filePath);// 设置当前所在 ...

- nj09---util、inherits、inspect、events、error

一.util全局变量 1.util.inherits(constructor,superConstructor) 此方法是一个实现对象间原型继承的函数.javaScript通过原型赋值来实现继承,细节 ...

- jquery去重

<!DOCTYPE HTML> <html> <head> <meta charset="utf-8"> <title> ...

- zzulioj--1841--so easy!麻麻再也不用担心我的数学了!(数学水题)

1841: so easy!麻麻再也不用担心我的数学了! Time Limit: 1 Sec Memory Limit: 128 MB Submit: 27 Solved: 15 SubmitSt ...

- Gojs学习史(一):基本定义

1. gojs定义 初始化时,先简化gojs本身的方法: var Go = go.GraphObject.make; //简化方法 1.1 画布定义 在声明了Go方法之后,接下来就是定义画布: myD ...

- Anaconda升级

Anaconda是可以进行升级的, 这样就省的重装一遍python全家桶了, 比如: conda update conda conda install anaconda=2018.12 就可以 ...

- 6.deque

#include <iostream> #include <deque> #include <algorithm> using namespace std; //序 ...