5.Dropout

import numpy as np

from keras.datasets import mnist

from keras.utils import np_utils

from keras.models import Sequential

from keras.layers import Dense,Dropout

from keras.optimizers import SGD

# 载入数据

(x_train,y_train),(x_test,y_test) = mnist.load_data()

# (60000,28,28)

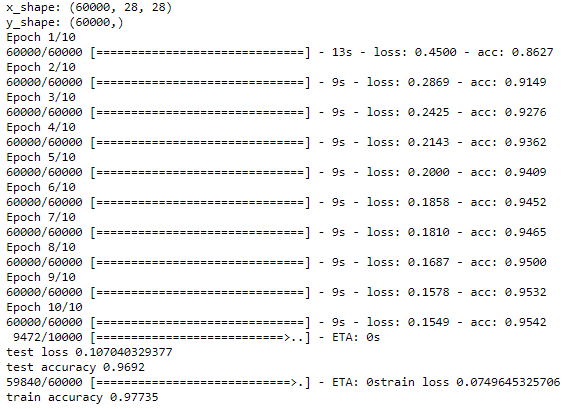

print('x_shape:',x_train.shape)

# (60000)

print('y_shape:',y_train.shape)

# (60000,28,28)->(60000,784)

x_train = x_train.reshape(x_train.shape[0],-1)/255.0

x_test = x_test.reshape(x_test.shape[0],-1)/255.0

# 换one hot格式

y_train = np_utils.to_categorical(y_train,num_classes=10)

y_test = np_utils.to_categorical(y_test,num_classes=10) # 创建模型

model = Sequential([

Dense(units=200,input_dim=784,bias_initializer='one',activation='tanh'),

Dropout(0.4),

Dense(units=100,bias_initializer='one',activation='tanh'),

Dropout(0.4),

Dense(units=10,bias_initializer='one',activation='softmax')

]) # 定义优化器

sgd = SGD(lr=0.2) # 定义优化器,loss function,训练过程中计算准确率

model.compile(

optimizer = sgd,

loss = 'categorical_crossentropy',

metrics=['accuracy'],

) # 训练模型

model.fit(x_train,y_train,batch_size=32,epochs=10) # 评估模型

loss,accuracy = model.evaluate(x_test,y_test)

print('\ntest loss',loss)

print('test accuracy',accuracy) loss,accuracy = model.evaluate(x_train,y_train)

print('train loss',loss)

print('train accuracy',accuracy)

5.Dropout的更多相关文章

- 在RNN中使用Dropout

dropout在前向神经网络中效果很好,但是不能直接用于RNN,因为RNN中的循环会放大噪声,扰乱它自己的学习.那么如何让它适用于RNN,就是只将它应用于一些特定的RNN连接上. LSTM的长期记 ...

- Deep Learning 23:dropout理解_之读论文“Improving neural networks by preventing co-adaptation of feature detectors”

理论知识:Deep learning:四十一(Dropout简单理解).深度学习(二十二)Dropout浅层理解与实现.“Improving neural networks by preventing ...

- 正则化方法:L1和L2 regularization、数据集扩增、dropout

正则化方法:防止过拟合,提高泛化能力 在训练数据不够多时,或者overtraining时,常常会导致overfitting(过拟合).其直观的表现如下图所示,随着训练过程的进行,模型复杂度增加,在tr ...

- 深度学习(dropout)

other_techniques_for_regularization 随手翻译,略作参考,禁止转载 www.cnblogs.com/santian/p/5457412.html Dropout: D ...

- Deep learning:四十一(Dropout简单理解)

前言 训练神经网络模型时,如果训练样本较少,为了防止模型过拟合,Dropout可以作为一种trikc供选择.Dropout是hintion最近2年提出的,源于其文章Improving neural n ...

- 简单理解dropout

dropout是CNN(卷积神经网络)中的一个trick,能防止过拟合. 关于dropout的详细内容,还是看论文原文好了: Hinton, G. E., et al. (2012). "I ...

- [转]理解dropout

理解dropout 原文地址:http://blog.csdn.net/stdcoutzyx/article/details/49022443 理解dropout 注意:图片都在github上 ...

- [CS231n-CNN] Training Neural Networks Part 1 : parameter updates, ensembles, dropout

课程主页:http://cs231n.stanford.edu/ ___________________________________________________________________ ...

- 正则化,数据集扩增,Dropout

正则化方法:防止过拟合,提高泛化能力 在训练数据不够多时,或者overtraining时,常常会导致overfitting(过拟合).其直观的表现如下图所示,随着训练过程的进行,模型复杂度增加,在tr ...

- [Neural Networks] Dropout阅读笔记

多伦多大学Hinton组 http://www.cs.toronto.edu/~rsalakhu/papers/srivastava14a.pdf 一.目的 降低overfitting的风险 二.原理 ...

随机推荐

- 【并行计算-CUDA开发】CUDA并行存储模型

CUDA并行存储模型 CUDA将CPU作为主机(Host),GPU作为设备(Device).一个系统中可以有一个主机和多个设备.CPU负责逻辑性强的事务处理和串行计算,GPU专注于执行高度线程化的并行 ...

- vue-cli@webpack@4打包分析命令

一.命令 npm run build --report 该命令在打包完之后,可以分析包的大小(如下图),从而分析那一块打包太大了可以进行优化处理.

- springboot打包的jar项目,不需要安装jdk环境启动

因为服务器上是JDK7,而springboot至少用JDK8才行,但是又因为是很老的项目,不是很清楚能不能换JDK8,有风险,因此选择以前项目用JDK7,而新的springboot用JDK8.步骤一: ...

- 项目实践 hrm项目的设计过程

人事管理系统的设计过程 一.数据库表和持久化类 1.1 进行需求分析,根据功能模块设计数据库表 1.2 设计持久化实体 面向对象分析,即根据系统需求提取出应用中的对象,将这些对象抽象成类,再抽 ...

- how to Simply Singleton Navigate the deceptively simple Singleton pattern---reference

http://www.javaworld.com/article/2073352/core-java/simply-singleton.html JAVA DESIGN PATTERNS By Dav ...

- pidof---找寻PID

pidof---找寻pid 1.根据守护进程找到pid [root@localhost ~]# pidof sshd 2542 1622 [root@localhost ~]# ps -ef | gr ...

- hdu 1576

老生常谈的问题 利用同余的思想 抽象出表达式 bx+9973y=n 然后用bx+9973y=1(题目给出了gcd(b,9973)=1) 求出基础解 y0 bx+9973y=n 的 基础解y=n*y0 ...

- jsp其实是一个java类

我们打开tomcat的D:\Program_Files\apache-tomcat-8.0.32\work\Catalina\localhost\venus\org\apache\jsp, 当我们访问 ...

- XML转换成DataTable

#region XML转dataset //str 是xml字符串 public static DataTable GetResultXMLToDataTable (string str,string ...

- bash 中的 :=、=、:-、-、=?、?、:+、+

bash 中的 :=.=.:-.-.=?.?.:+.+ 来源 https://www.cnblogs.com/fhefh/archive/2011/04/22/2024750.html 变量替换和变量 ...