spark 系列之一 RDD的使用

spark中常用的两种数据类型,一个是RDD,一个是DataFrame,本篇主要介绍RDD的一些应用场景见代码

本代码的应用场景是在spark本地调试(windows环境)

- /**

- * 创建 sparkSession对象

- */

- val sparkSession = SparkSession.builder()

- .appName("TextFile")

- .master("local")

- .getOrCreate()

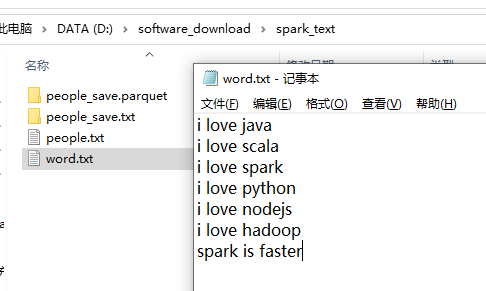

word.txt 的文本内容如下

wordcount:三个算子搞定 flatMap 是把数据打平,map是对打平的数据每个计数一,reduceBykey是按照key进行分类汇总。

- /**

- * wordCount 程序,三个算子搞定

- */

- val peopleRDD1 = sparkSession.sparkContext

- .textFile("file:///D:/software_download/spark_text/word.txt")

- .flatMap(line=>line.split(" "))

- .map(word=>(word,1))

- .reduceByKey((a,b)=>a+b)

- peopleRDD1.foreach(println)

Result:

(scala,1)

(faster,1)

(is,1)

(spark,2)

(hadoop,1)

(love,6)

(i,6)

(python,1)

(nodejs,1)

(java,1)

按照key进行分组

- /**

- * 分组

- */

- val peopleRDD2 = sparkSession.sparkContext

- .textFile("file:///D:/software_download/spark_text/word.txt")

- .flatMap(line=>line.split(" "))

- .map(word=>(word,1))

- .groupByKey()

- peopleRDD2.foreach(println)

Result:

(scala,CompactBuffer(1))

(spark,CompactBuffer(1, 1))

(is,CompactBuffer(1))

(faster,CompactBuffer(1))

(hadoop,CompactBuffer(1))

(love,CompactBuffer(1, 1, 1, 1, 1, 1))

(i,CompactBuffer(1, 1, 1, 1, 1, 1))

(python,CompactBuffer(1))

(nodejs,CompactBuffer(1))

(java,CompactBuffer(1))

遍历RDD的keys和values,RDD中存放的是一个个对象,这点跟DataFrame不同,RDD中的对象对外的表现是黑盒的,即你不知道RDD中具体的字段是什么。DataFrame则不同,你可以清晰的看到DataFrame中所存放对象的内部结构。

- /**

- * RDD keys与values的遍历

- */

- peopleRDD1.keys.foreach(println)

- peopleRDD1.values.foreach(println)

Result:

scala

faster

is

spark

hadoop

love

i

python

nodejs

java

1

1

1

2

1

6

6

1

1

1

RDD 的其它操作,

- /**

* 只针对value的值进行操作,以下两种操作等效,都是对key值加1操作

*/

peopleRDD1.sortByKey().map(x=>(x._1,x._2+1)).foreach(println)

peopleRDD1.sortByKey().mapValues(x=>x+1).foreach(println)

//按照value值进行排序

peopleRDD1.sortBy(x=>x._2,ascending = true).foreach(println)

//按照key值进行排序

peopleRDD1.sortByKey(ascending = true).foreach(println)

/**

* RDD之间的join操作

*/

val pairRDD1 = sparkSession.sparkContext.parallelize(Array(("spark",1),("spark",2),("hadoop",3),("hadoop",5)))

val pairRDD2 = sparkSession.sparkContext.parallelize(Array(("spark","fast")))

val RDD1_join_RDD2 = pairRDD1.join(pairRDD2)

RDD1_join_RDD2.foreach(println)

思考题: 求该rdd,按照key进行分组后,value值得平均值,答案如下。

求:写代码

- val rdd = sparkSession.sparkContext.parallelize(Array(("spark",2),("hadoop",6),("hadoop",4),("spark",6)))

Result:

(spark,4)

(hadoop,5)

spark 系列之一 RDD的使用的更多相关文章

- Spark RDD概念学习系列之RDD的checkpoint(九)

RDD的检查点 首先,要清楚.为什么spark要引入检查点机制?引入RDD的检查点? 答:如果缓存丢失了,则需要重新计算.如果计算特别复杂或者计算耗时特别多,那么缓存丢失对于整个Job的影响是不容 ...

- Spark RDD概念学习系列之RDD的缓存(八)

RDD的缓存 RDD的缓存和RDD的checkpoint的区别 缓存是在计算结束后,直接将计算结果通过用户定义的存储级别(存储级别定义了缓存存储的介质,现在支持内存.本地文件系统和Tachyon) ...

- Spark RDD概念学习系列之RDD的5大特点(五)

RDD的5大特点 1)有一个分片列表,就是能被切分,和Hadoop一样,能够切分的数据才能并行计算. 一组分片(partition),即数据集的基本组成单位,对于RDD来说,每个分片都会被一个计 ...

- Spark RDD概念学习系列之rdd的依赖关系彻底解密(十九)

本期内容: 1.RDD依赖关系的本质内幕 2.依赖关系下的数据流视图 3.经典的RDD依赖关系解析 4.RDD依赖关系源码内幕 1.RDD依赖关系的本质内幕 由于RDD是粗粒度的操作数据集,每个Tra ...

- Spark系列-核心概念

Spark系列-初体验(数据准备篇) Spark系列-核心概念 一. Spark核心概念 Master,也就是架构图中的Cluster Manager.Spark的Master和Workder节点分别 ...

- Spark深入之RDD

目录 Part III. Low-Level APIs Resilient Distributed Datasets (RDDs) 1.介绍 2.RDD代码 3.KV RDD 4.RDD Join A ...

- Spark系列之二——一个高效的分布式计算系统

1.什么是Spark? Spark是UC Berkeley AMP lab所开源的类Hadoop MapReduce的通用的并行计算框架,Spark基于map reduce算法实现的分布式计算,拥有H ...

- Spark计算模型-RDD介绍

在Spark集群背后,有一个非常重要的分布式数据架构,即弹性分布式数据集(Resilient Distributed DataSet,RDD),它是逻辑集中的实体,在集群中的多台集群上进行数据分区.通 ...

- spark 中的RDD编程 -以下基于Java api

1.RDD介绍: RDD,弹性分布式数据集,即分布式的元素集合.在spark中,对所有数据的操作不外乎是创建RDD.转化已有的RDD以及调用RDD操作进行求值.在这一切的背后,Spark会自动 ...

随机推荐

- SPG-Net: Segmentation Prediction and Guidance Network for Image Inpainting

SPG-Net: Segmentation Prediction and Guidance Network for Image Inpainting pytorch 引言 利用语义分割获取空洞的边缘信 ...

- 关于 [栈溢出后jmp esp执行shellcode] 原理分析

原文地址:https://blog.csdn.net/lixiangminghate/article/details/53333710 正常情况下,函数栈分布图如下: 即,返回地址被改为一段缓存区的地 ...

- 一条 sql 的执行过程详解

写操作执行过程 如果这条sql是写操作(insert.update.delete),那么大致的过程如下,其中引擎层是属于 InnoDB 存储引擎的,因为InnoDB 是默认的存储引擎,也是主流的,所以 ...

- 学习PKI技术【理论+实战】

1.预备知识 PKI(Public Key Infrastructure)定义 PKI:利用公钥理论和技术建立的提供网络信息安全服务的基础设施.为用户提供所需的密钥和证书管理,用户可以利用PKI平台提 ...

- RedHat-Linux操作指令第1篇

不同的linux系统切换方式会稍有一点差别 从图形界面切换到字符界面:Alt+F(1-8) 或者 Alt+Ctrl+Shift+F(1-8) 从字符界面切换回图形界面:Alt+F7 字符界面启动到图形 ...

- GBK宽字节注入SQL

SQL注入:宽字节注入(GBK双字节绕过) 2015-06-09lyiang 宽字节注入的作用是非常大的,实际上在代码层的防御一般不外乎两种,一是反斜杠转义,而就是replace替换成空字节,之前的替 ...

- python 保存list,map方法

1. 保存list import numpy as np a = [1,2,3,4,5] np.save("number.npy", a) k = np.load("nu ...

- c++11-17 模板核心知识(十五)—— 解析模板之依赖型类型名称与typename Dependent Names of Types

模板名称的问题及解决 typename规则 C++20 typename 上篇文章c++11-17 模板核心知识(十四)-- 解析模板之依赖型模板名称 Dependent Names of Templ ...

- 「生产事故」MongoDB复合索引引发的灾难

前情提要 11月末我司商品服务的MongoDB主库曾出现过严重抖动.频繁锁库等情况. 由于诸多业务存在插入MongoDB.然后立即查询等逻辑,因此项目并未开启读写分离. 最终定位问题是由于:服务器自身 ...

- MyBatis if 标签的坑,居然被我踩到了。。。

事件的原因是这样的,需求是按条件查数据然后给前端展示就行了,写的时候想着挺简单的,不就是使用 MyBatis 动态 SQL 去查询数据吗? 现实还是很残酷的,等我写完上完 UAT 后,前端同学说根据s ...