C#最基本的小说爬虫

新手学习C#,自己折腾弄了个简单的小说爬虫,实现了把小说内容爬下来写入txt,还只能爬指定网站。

第一次搞爬虫,涉及到了网络协议,正则表达式,弄得手忙脚乱跑起来效率还差劲,慢慢改吧。

爬的目标:http://www.166xs.com/xiaoshuo/83/83557/

一、先写HttpWebRequest把网站扒下来

这里有几个坑,大概说下:

第一个就是记得弄个代理IP爬网站,第一次忘了弄代理然后ip就被封了。。。。。

第二个就是要判断网页是否压缩,第一次没弄结果各种转码gbk utf都是乱码。后面解压就好了。

/// <summary>

/// 抓取网页并转码

/// </summary>

/// <param name="url"></param>

/// <param name="post_parament"></param>

/// <returns></returns>

public string HttpGet(string url, string post_parament)

{

string html;

HttpWebRequest Web_Request = (HttpWebRequest)WebRequest.Create(url);

Web_Request.Timeout = ;

Web_Request.Method = "GET";

Web_Request.UserAgent = "Mozilla/4.0";

Web_Request.Headers.Add("Accept-Encoding", "gzip, deflate");

//Web_Request.Credentials = CredentialCache.DefaultCredentials; //设置代理属性WebProxy-------------------------------------------------

WebProxy proxy = new WebProxy("111.13.7.120", );

//在发起HTTP请求前将proxy赋值给HttpWebRequest的Proxy属性

Web_Request.Proxy = proxy; HttpWebResponse Web_Response = (HttpWebResponse)Web_Request.GetResponse(); if (Web_Response.ContentEncoding.ToLower() == "gzip") // 如果使用了GZip则先解压

{

using (Stream Stream_Receive = Web_Response.GetResponseStream())

{

using (var Zip_Stream = new GZipStream(Stream_Receive, CompressionMode.Decompress))

{

using (StreamReader Stream_Reader = new StreamReader(Zip_Stream, Encoding.Default))

{

html = Stream_Reader.ReadToEnd();

}

}

}

}

else

{

using (Stream Stream_Receive = Web_Response.GetResponseStream())

{

using (StreamReader Stream_Reader = new StreamReader(Stream_Receive, Encoding.Default))

{

html = Stream_Reader.ReadToEnd();

}

}

} return html;

}

二、下面就是用正则处理内容了,由于正则表达式不熟悉所以重复动作太多。

1.先获取网页内容

IWebHttpRepository webHttpRepository = new WebHttpRepository();

string html = webHttpRepository.HttpGet(Url_Txt.Text, "");

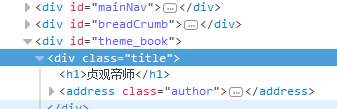

2.获取书名和文章列表

书名

文章列表

string Novel_Name = Regex.Match(html, @"(?<=<h1>)([\S\s]*?)(?=</h1>)").Value; //获取书名

Regex Regex_Menu = new Regex(@"(?is)(?<=<dl class=""book_list"">).+?(?=</dl>)");

string Result_Menu = Regex_Menu.Match(html).Value; //获取列表内容

Regex Regex_List = new Regex(@"(?is)(?<=<dd>).+?(?=</dd>)");

var Result_List = Regex_List.Matches(Result_Menu); //获取列表集合

3.因为章节列表前面有多余的<dd>,所以要剔除

int i = ; //计数

string Menu_Content = ""; //所有章节

foreach (var x in Result_List)

{

if (i < )

{

//前面五个都不是章节列表,所以剔除

}

else

{

Menu_Content += x.ToString();

}

i++;

}

4.然后获取<a>的href和innerHTML,然后遍历访问获得内容和章节名称并处理,然后写入txt

Regex Regex_Href = new Regex(@"(?is)<a[^>]*?href=(['""]?)(?<url>[^'""\s>]+)\1[^>]*>(?<text>(?:(?!</?a\b).)*)</a>");

MatchCollection Result_Match_List = Regex_Href.Matches(Menu_Content); //获取href链接和a标签 innerHTML string Novel_Path = Directory.GetCurrentDirectory() + "\\Novel\\" + Novel_Name + ".txt"; //小说地址

File.Create(Novel_Path).Close();

StreamWriter Write_Content = new StreamWriter(Novel_Path); foreach (Match Result_Single in Result_Match_List)

{

string Url_Text = Result_Single.Groups["url"].Value;

string Content_Text = Result_Single.Groups["text"].Value; string Content_Html = webHttpRepository.HttpGet(Url_Txt.Text + Url_Text, "");//获取内容页 Regex Rege_Content = new Regex(@"(?is)(?<=<p class=""Book_Text"">).+?(?=</p>)");

string Result_Content = Rege_Content.Match(Content_Html).Value; //获取文章内容 Regex Regex_Main = new Regex(@"( )(.*)");

string Rsult_Main = Regex_Main.Match(Result_Content).Value; //正文

string Screen_Content = Rsult_Main.Replace(" ", "").Replace("<br />", "\r\n"); Write_Content.WriteLine(Content_Text + "\r\n");//写入标题

Write_Content.WriteLine(Screen_Content);//写入内容

} Write_Content.Dispose();

Write_Content.Close();

MessageBox.Show(Novel_Name+".txt 创建成功!");

System.Diagnostics.Process.Start(Directory.GetCurrentDirectory() + "\\Novel\\");

三、小说写入成功

C#最基本的小说爬虫的更多相关文章

- 使用scrapy制作的小说爬虫

使用scrapy制作的小说爬虫 爬虫配套的django网站 https://www.zybuluo.com/xuemy268/note/63660 首先是安装scrapy,在Windows下的安装比 ...

- Scrapy - 小说爬虫

实例解析 - 小说爬虫 页面分析 共有三级页面 一级页面 大目录 二级页面 章节目录 三级界面 章节内容 爬取准备 一级界面 http://www.daomubiji.com/ 二级页面xpath 直 ...

- python基础爬虫,翻译爬虫,小说爬虫

基础爬虫: # -*- coding: utf-8 -*- import requests url = 'https://www.baidu.com' # 注释1 headers = { # 注释2 ...

- Node.js 实现简单小说爬虫

最近因为剧荒,老大追了爱奇艺的一部网剧,由丁墨的同名小说<美人为馅>改编,目前已经放出两季,虽然整部剧槽点满满,但是老大看得不亦乐乎,并且在看完第二季之后跟我要小说资源,直接要奔原著去看结 ...

- 使用python书写的小说爬虫

1.写了一个简单的网络爬虫 初期1 (后期将会继续完善) #小说的爬取 import requests import random from bs4 import BeautifulSoup base ...

- 基于nodeJS的小说爬虫实战

背景与需求分析 最近迷恋于王者荣耀.斗鱼直播与B站吃播视频,中毒太深,下班之后无心看书. 为了摆脱现状,能习惯看书,我开始看小说了,然而小说网站广告多而烦,屌丝心态不愿充钱,于是想到了爬虫. 功能分析 ...

- 【Python】我的第一个完整的小说爬虫

写在开头 纪念我的第一个爬虫程序,一共写了三个白天,其中有两个上午没有看,中途遇到了各种奇怪的问题,伴随着他们的解决,对于一些基本的操作也弄清楚了.果然,对于这些东西的最号的学习方式,就是在使用中学习 ...

- python写的有声小说爬虫

querybook.py from bs4 import BeautifulSoup from lxml import html import xml import requests import s ...

- python爬虫之小说网站--下载小说(正则表达式)

python爬虫之小说网站--下载小说(正则表达式) 思路: 1.找到要下载的小说首页,打开网页源代码进行分析(例:https://www.kanunu8.com/files/old/2011/244 ...

随机推荐

- 6.26学习 异步委托回调函数 VS 多线程 VS 并行处理

描述: 我现在是轮询着构建实例,然后这个实例去执行一个方法,但是执行方法需要大约10s时间,全部轮询下来需要很长时间.所以我现在要更改,头给了我两个方法,1多线程 2异步委托回调函数. 异步委托回调函 ...

- 常用bash命令

p.p1 { margin: 0.0px 0.0px 0.0px 0.0px; font: 12.0px "Helvetica Neue"; color: #454545 } p. ...

- C++与类型转换相关的四个关键字及其特点

1.reinterpret_cast (expression) type-id 必须是一个指针.引用.算术类型.函数指针或者成员指针. 它可以把一个指针转换成一个整数,也可以把一个整数转换成一个指针( ...

- JAVA实用案例之验证码开发

验证码在很多地方都会遇到,实现的方法和形式也有很多,主要的目的就是为了安全,防止一些恶意的攻击等.说实话那么多年竟然没注意过这东西,原理很简单,贴出来给大家做个参考. 1.简单介绍 一般稍微有些经验的 ...

- Docker 入门实践

欢迎大家前往腾讯云技术社区,获取更多腾讯海量技术实践干货哦~ 作者:张戈 导语 本文从新手视角记录了一个实际的Dokcer应用场景从创建.上传直到部署的详细过程,并简单的介绍了腾讯云容器服务的使用方法 ...

- 如何用比较快速的方法掌握Spring的核心——依赖注入,Java web轻量级开发面试教程 读书笔记

我们知道,Java方面的高级程序员一定得掌握Spring的技能,其中包括Spring 依赖注入(IOC),面向切面(AOP),和数据库的整合(比如和Hibernate整合或声明式事务等)以及Sprin ...

- 在STEP7 TIA PORTAL中,设置模块的地址和设备名(Device name)

assign device name, ip address for PROFINET componet in TIA Portal 方法1: PLC --> online & diag ...

- Android 日夜间切换Demo

这是其中一种实现模式,也是比较麻烦的一种,首先写布局,不多说上代码 activity_main.xml <?xml version="1.0" encoding=" ...

- 三种计算c#程序运行时间的方法

三种计算c#程序运行时间的方法 第一种: 利用 System.DateTime.Now // example1: System.DateTime.Now method DateTime dt1 = S ...

- Spring mybatis源码篇章-XMLLanguageDriver解析sql包装为SqlSource

前言:通过阅读源码对实现机制进行了解有利于陶冶情操,承接前文Spring mybatis源码篇章-MybatisDAO文件解析(二) 首先了解下sql mapper的动态sql语法 具体的动态sql的 ...